Une nouvelle chanson des Beatles, la découverte de géoglyphes au Pérou, le pilotage automatique des drones de livraison autonomes, le développement de thérapies non médicamenteuses…

Les applications concrètes et potentielles de l’intelligence artificielles sont de plus en plus nombreuses. Il en est de même pour les outils de l’IA accessibles au grand public, tels que ChatGPT, Dall-E, Midjourney, ou encore Bard. Ces outils sont capables de mener de nombreuses actions, entre la production de textes, d’images, de vidéos, et de voix.

Face à cette émergence et à cette utilisation massive de l’IA, les États-Unis, le Royaume-Uni, la Chine et l’Union Européenne souhaitent mettre en place un règlement sur l’intelligence artificielle.

Le 14 juin dernier, le Parlement Européen a voté en faveur d’une initiative de régulation de l’intelligence artificielle, appelée l’IA Act, visant à créer un cadre juridique complet et uniforme sur la scène européenne, tant pour l’utilisation que la commercialisation des technologies d'intelligence artificielle.

En réalité, ce projet est en préparation depuis plusieurs années, avec une version initiale datant d’avril 2021. Toutefois, ce premier jet s’est vu confronté au lancement d’outils intelligents tels que ceux mentionnés plus haut. C’est notamment en novembre 2022 que ChatGPT s’ouvre au public, obligeant une nouvelle fois la Commission à adapter le texte du projet. Face à la complexité de l’intelligence artificielle et aux nombreuses technologies et domaines qu’elle englobe, ce texte est devenu le plus amendé de l'histoire de la législation européenne.

« Il a donc fallu que nous nous adaptions à cette nouvelle réalité sociétale en l'incluant dans les travaux parlementaires qui étaient en cours », reconnaît Geoffroy Didier, vice-président de la commission Intelligence artificielle au Parlement européen.

La prochaine étape de la mise en place de ce règlement européen sur l’intelligence artificielle repose sur les Etats membres, qui doivent encore négocier sur la version finale du texte et la législation qui limiteraient les risques des technologies de l’intelligence artificielle tout en favorisant l’innovation.

Ce texte pourrait être finalisé d'ici la fin de l'année, avant une entrée en application à horizon 2026.

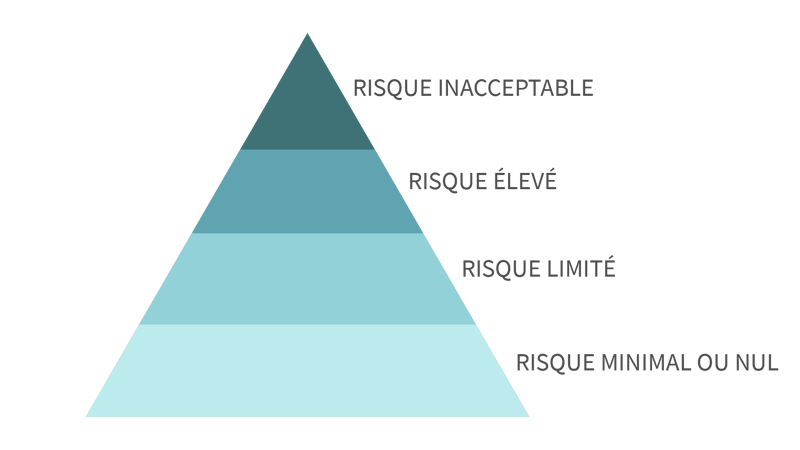

Ce règlement sur l’intelligence artificielle détermine 4 niveaux de risques quant à l’utilisation et la commercialisation des technologies d'intelligence artificielle. Chacun de ces niveau amène une réponse législative différente.

Du plus faible au plus fort, les risques définis selon le règlement européen sur l’intelligence artificielle sont les suivants :

Parmi les risques inacceptables du règlement sur l’intelligence artificielle se retrouveront notamment :

Les risques élevés mentionnés dans le règlement européen sur l’intelligence artificielle représentent les outils qui, en cas de défaillance, pourraient créer un risque élevé pour la santé, la sécurité ou les droits fondamentaux des personnes physiques. Parmi ceux-ci se retrouveront notamment :

La classification des robots conversationnels comme ChatGPT dans la catégorie « risque élevé » ou « risque inacceptable » n’est pas encore clairement définie.

Toutefois, certaines des obligations auxquelles seront soumis ces outils ont déjà été énoncées, dont :

En plus de cette régulation sur l’intelligence artificielle, en mars 2023, un moratoire de 6 mois a été demandé par des experts de l’IA quant aux recherches et évolutions sur les intelligences artificielles. La raison principale derrière cette demande concernait les « risques majeurs » que cette technologie pourrait faire courir à « l’humanité ».

Les exigences de ce moratoire, présenté sous la forme d’une pétition sur le site futureoflife.org, étaient les suivantes :

Parmi ces experts se trouvaient notamment Elon Musk, CEO de Twitter et fondateur de SpaceX et de Tesla, Yuval Noah Harari, auteur de « Sapiens », et Sam Altman, patron d’OpenAI et créateur de ChatGPT. Celui-ci se dit « un petit peu effrayé » par l’application qu’il a lui-même conceptualisée, et redoute que celle-ci soit utilisée pour faire de « la désinformation à grande échelle ou des cyberattaques ».

Ces signataires de la pétition déclarent : « Ces derniers mois ont vu les laboratoires d’IA s’enfermer dans une course incontrôlée pour développer et déployer des cerveaux numériques toujours plus puissants, que personne – pas même leurs créateurs – ne peut comprendre, prédire ou contrôler de manière fiable ».

À échelle nationale, les expert belges de l’intelligence artificielle semblent s’accorder sur le fait qu’un règlement européen sur l’intelligence artificielle doive voir le jour, et que l’éducation à celle-ci est nécessaire. Toutefois, certains redoutent un cadre légal trop contraignant qui viendrait à freiner l’innovation.

Vous souhaitez en savoir plus sur l’intelligence artificielle, ses risques et opportunités pour votre entreprise ?

Découvrez l’atelier pratique « AI-VOLUTION : Application de l’intelligence artificielle en entreprise » !

Sources : https://www.francetvinfo.fr/replay-radio/le-choix-franceinfo/pour-que-ces-technologies-ne-soient-pas-utilisees-a-mauvais-escient-l-union-europeenne-propose-un-reglement-pour-reguler-les-intelligences-artificielles_5855474.html - https://www.rtl.fr/actu/sciences-tech/intelligence-artificielle-les-3-propositions-de-l-union-europeenne-pour-reguler-chatgpt-et-les-autres-systemes-7900274721 - https://www.rtbf.be/article/l-intelligence-artificielle-n-a-plus-besoin-de-modele-il-y-a-un-vrai-sujet-d-inquietude-11212478

These Stories on Digital Transformation, Innovation & Change

Copyright © 2023 HEC Liège Executive Education | Conditions Générales de Vente des Formations Inter-Entreprises | Aides à la Formation | Protection de la Vie Privée

Developed by @Stratenet

Dites-nous ce que vous en pensez !